在近期科技界的一次重大突破中,OpenAI推出了一項名為RFT(基于強化學習的微調(diào))的新型訓(xùn)練方法,該方法迅速吸引了全球的目光。RFT通過結(jié)合強化學習與監(jiān)督微調(diào)技術(shù),實現(xiàn)了在有限標注數(shù)據(jù)下模型性能的顯著提升。緊接著,這一創(chuàng)新技術(shù)被百度智能云千帆ModelBuilder平臺引入國內(nèi),成為首個全面支持RFT的大模型開發(fā)平臺,為企業(yè)開發(fā)者開辟了一條高效、低成本的大模型開發(fā)路徑。

RFT技術(shù)的核心在于其融合了強化學習(RL)與微調(diào)(Fine-tuning)的優(yōu)勢,打破了傳統(tǒng)訓(xùn)練方式對于大量人工標注數(shù)據(jù)的依賴。通過引入一個稱為Grader的模塊,RFT能夠自動比較模型的輸出與參考答案,并生成0-1之間的量化獎勵信號,以此驅(qū)動模型的優(yōu)化過程。這種機制不僅提高了數(shù)據(jù)利用效率,還使模型能夠自主思考,強化正確的思維路徑,抑制錯誤的路徑。

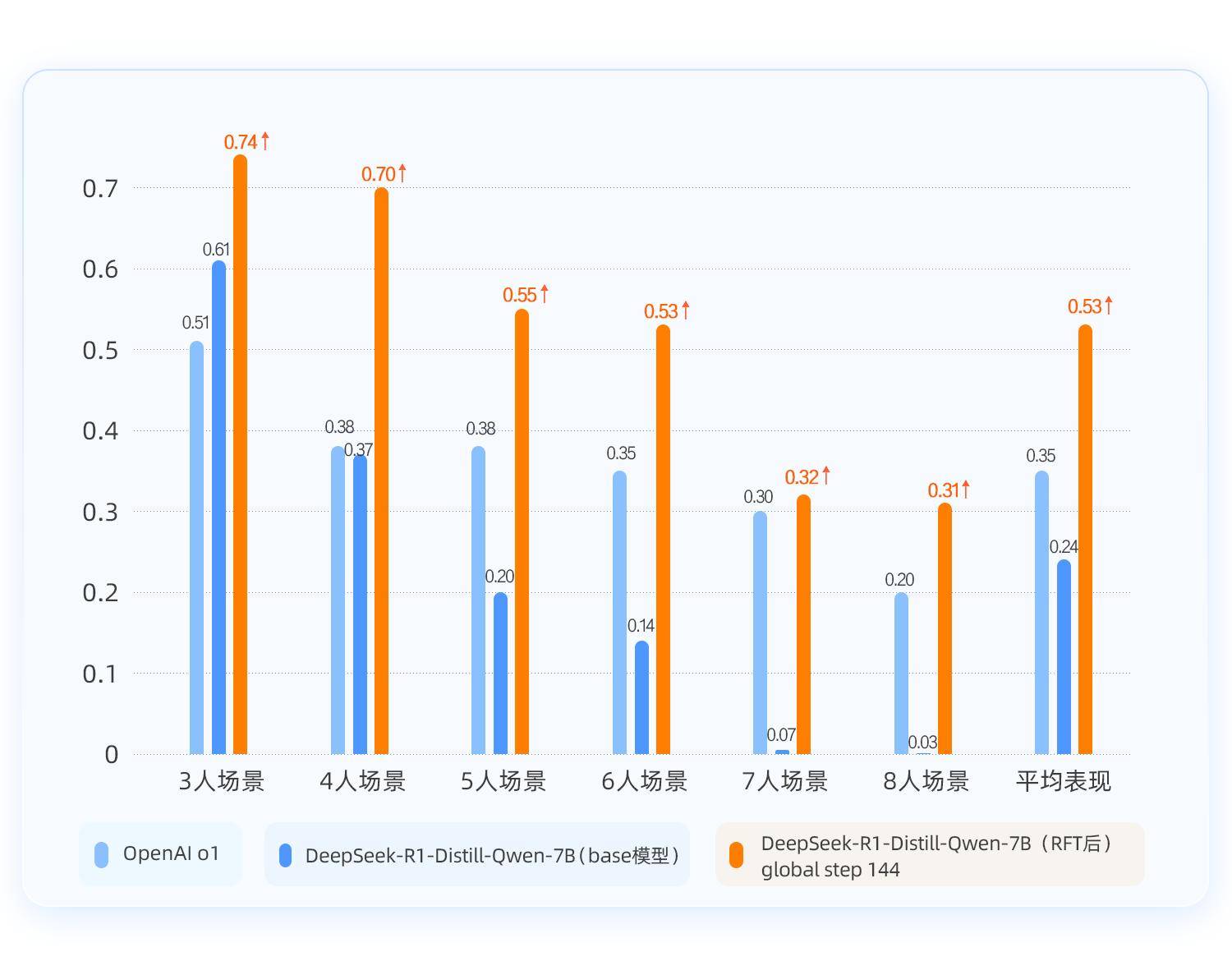

在實際應(yīng)用中,RFT展現(xiàn)出了令人矚目的效果。在復(fù)雜場景下,僅需4500條訓(xùn)練數(shù)據(jù),RFT就能使模型達到令人滿意的性能水平。在涉及邏輯推理的任務(wù)中,RFT訓(xùn)練后的模型在準確率上有了顯著提升,甚至超越了OpenAI的o1模型。這一成就不僅體現(xiàn)在平均準確率的提高上,更在于模型在面對不同難度任務(wù)時的穩(wěn)定表現(xiàn)。

百度智能云千帆ModelBuilder平臺上的RFT訓(xùn)練流程簡潔高效。用戶只需按照平臺指引,創(chuàng)建RFT訓(xùn)練任務(wù),選擇基礎(chǔ)模型,并配置獎勵規(guī)則。隨后,準備包含問題和參考答案的訓(xùn)練數(shù)據(jù),即可開始訓(xùn)練過程。訓(xùn)練完成后,用戶可以在平臺上一鍵部署模型,并通過自動評估任務(wù)快速獲得模型效果反饋。

以實際案例為例,在“好人/壞人”推理場景中,RFT訓(xùn)練后的模型在3-8人復(fù)雜度遞增的任務(wù)中,平均準確率相比基礎(chǔ)模型提升了29%。這一提升不僅體現(xiàn)在準確率的數(shù)字上,更在于模型在推理過程中的清晰度和邏輯性。在RFT訓(xùn)練前,基礎(chǔ)模型的輸出答案和思考過程往往存在明顯錯誤,尤其是在任務(wù)難度增加時,模型甚至會出現(xiàn)語言混亂的情況。而經(jīng)過RFT訓(xùn)練后,模型的輸出答案準確,思考過程也更加條理清晰。

RFT技術(shù)還展現(xiàn)出了更高的訓(xùn)練天花板。在復(fù)雜問題場景下,RFT訓(xùn)練后的模型相比傳統(tǒng)監(jiān)督微調(diào)方法(SFT)在準確率上有了更顯著的提升。這表明RFT在處理復(fù)雜任務(wù)時具有更強的適應(yīng)性和優(yōu)化能力。

百度智能云千帆ModelBuilder平臺的RFT訓(xùn)練流程不僅簡化了大模型開發(fā)的復(fù)雜度,還降低了生成式AI應(yīng)用落地的門檻。通過RFT技術(shù),企業(yè)開發(fā)者能夠更高效地利用有限的數(shù)據(jù)資源,訓(xùn)練出性能卓越的模型,為各行業(yè)的智能化轉(zhuǎn)型提供有力支持。