近期,一起針對蘋果公司的訴訟案件引起了廣泛關注。這起案件涉及蘋果在2022年取消的兒童性虐待材料(CSAM)檢測計劃,該計劃原本旨在通過設備端哈希值系統掃描iCloud中的圖片,以檢測和阻止CSAM的傳播。

一位現年27歲的女性,曾在童年時期遭受性虐待,她以化名對蘋果公司提起了訴訟。原告聲稱,蘋果違背了其保護受害者的承諾,特別是在CSAM檢測功能被取消后,她遭受性虐待的圖片被上傳到iCloud并廣泛傳播。這一發現是在執法部門通知她后得知的,相關圖片是通過在佛蒙特州查獲的一臺MacBook上傳至iCloud的。

原告在訴訟中表示,蘋果取消CSAM檢測功能的決定,使其遭受性虐待的圖片得以繼續傳播,這等同于向消費者銷售了“有缺陷的產品”,對她這樣的用戶群體造成了嚴重傷害。為此,她要求蘋果改變其做法,并向可能多達2680名其他符合條件的受害者提供賠償。根據法律,這類受害者每人有權獲得至少15萬美元的賠償,如果全部受害者成功獲得賠償,蘋果將面臨超過12億美元(約87.28億元人民幣)的賠償金額。

類似的情況在北卡羅來納州也發生過。一名9歲的CSAM受害者指控蘋果,稱她通過iCloud鏈接收到了陌生人發送的非法視頻,并被誘導拍攝并上傳了類似內容。蘋果對此提出了一項駁回案件的動議,引用聯邦法規第230條,試圖免除其對用戶上傳到iCloud的材料的責任。然而,法院近期裁定,這一法律保護僅適用于積極內容審核的情形,這可能削弱了蘋果的抗辯理由。

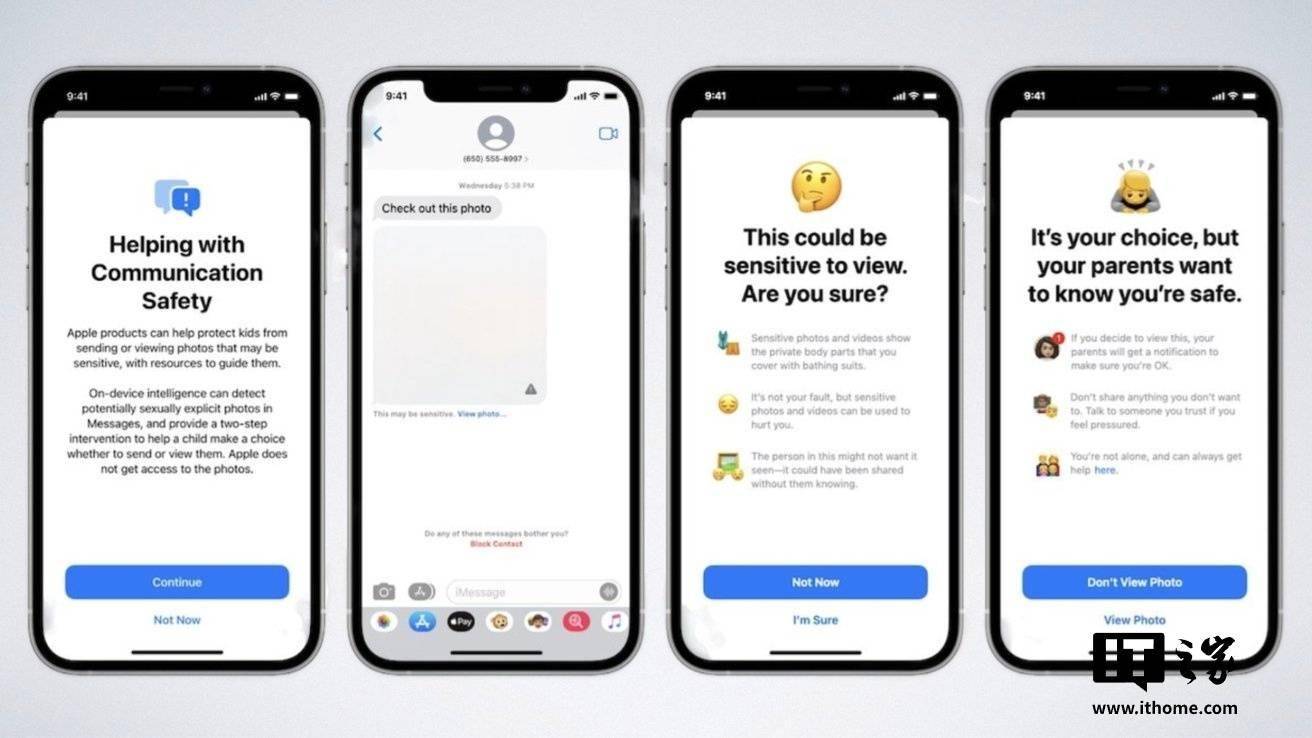

面對新訴訟,蘋果發言人弗雷德·塞恩茲表示,蘋果認為兒童性虐待材料是極其惡劣的,公司一直致力于在不損害用戶隱私和安全的前提下,積極打擊相關犯罪。他提到,蘋果已經擴展了信息應用中的裸露內容檢測功能,并允許用戶舉報有害材料。然而,原告及其律師瑪格麗特·馬比認為,蘋果的措施還遠遠不夠,未能充分履行其保護受害者的責任。