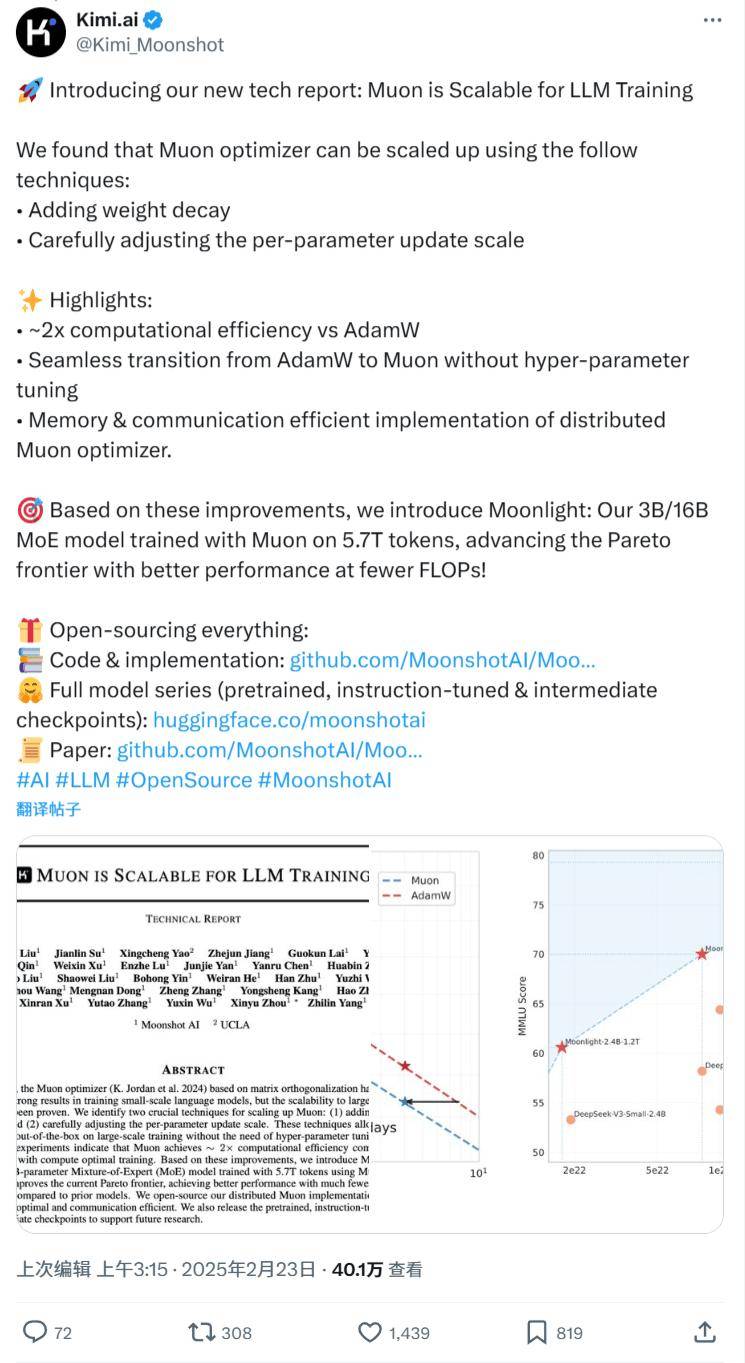

近期,人工智能領(lǐng)域迎來了一項引人注目的技術(shù)創(chuàng)新。知名技術(shù)團(tuán)隊月之暗面Kimi發(fā)布了一項關(guān)于Muon優(yōu)化器的新技術(shù)報告,并隨之推出了名為“Moonlight”的混合專家模型(MoE)。這款模型在Muon優(yōu)化器的基礎(chǔ)上進(jìn)行了訓(xùn)練,擁有30億至160億不等的參數(shù)規(guī)模。

Moonlight模型在訓(xùn)練過程中采用了5.7萬億個token的數(shù)據(jù)量,并且在減少浮點運算次數(shù)(FLOPs)的同時,實現(xiàn)了卓越的性能表現(xiàn)。這一成果不僅提升了帕累托效率邊界,更為大規(guī)模的語言模型訓(xùn)練提供了新的思路。

月之暗面團(tuán)隊表示,Muon優(yōu)化器通過引入權(quán)重衰減和精細(xì)調(diào)整每個參數(shù)更新幅度的技術(shù),實現(xiàn)了在大規(guī)模訓(xùn)練中的高效應(yīng)用。這些創(chuàng)新技術(shù)使得Muon優(yōu)化器無需繁瑣的超參數(shù)調(diào)優(yōu),即可直接應(yīng)用于實際訓(xùn)練任務(wù)。

據(jù)團(tuán)隊介紹,在擴展法則實驗中,Muon優(yōu)化器相較于計算最優(yōu)訓(xùn)練的AdamW優(yōu)化器,實現(xiàn)了約2倍的計算效率提升。這一顯著優(yōu)勢使得Muon優(yōu)化器在處理大規(guī)模數(shù)據(jù)集時更加得心應(yīng)手。

本次發(fā)布的Moonlight模型采用了名為Moonlight-16B-A3B的具體配置,總參數(shù)量達(dá)到15.29B,其中激活參數(shù)為2.24B。在5.7T token的訓(xùn)練數(shù)據(jù)支持下,Moonlight模型展現(xiàn)出了卓越的性能表現(xiàn),不僅突破了當(dāng)前的Pareto前沿,還在大幅減少FLOPs的情況下實現(xiàn)了比以往模型更優(yōu)的性能。

為了方便其他研究人員和開發(fā)者利用這一創(chuàng)新成果,月之暗面團(tuán)隊還開源了一個分布式版本的Muon實現(xiàn)。該實現(xiàn)在內(nèi)存使用和通信效率上都進(jìn)行了優(yōu)化,旨在提高整體性能和易用性。團(tuán)隊還發(fā)布了預(yù)訓(xùn)練模型、經(jīng)過指令調(diào)優(yōu)的模型以及中間訓(xùn)練檢查點,為未來的研究工作提供了有力支持。

對于對這項技術(shù)感興趣的研究人員和開發(fā)者來說,可以通過訪問GitHub和Hugging Face平臺,獲取更多關(guān)于Moonlight模型和Muon優(yōu)化器的詳細(xì)信息。