英偉達近期在視覺-語言模型領域取得了重大突破,推出了一款名為Eagle 2.5的新型模型。這款模型專注于長上下文多模態學習,特別擅長處理大規模視頻和圖像。

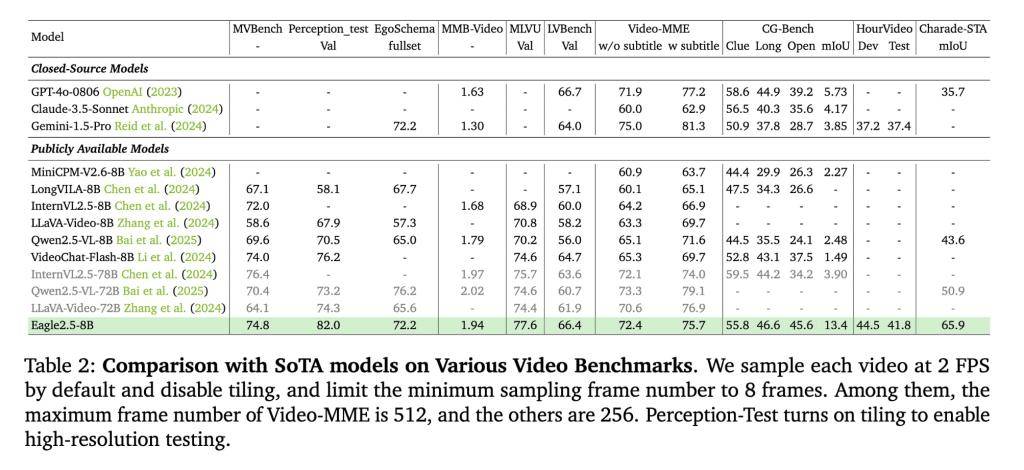

Eagle 2.5盡管參數規模僅為8B,但在Video-MME基準測試中展現出了驚人的性能。在處理512幀輸入的測試中,它獲得了72.4%的高分,這一成績足以媲美規模更大的模型,如Qwen2.5-VL-72B和InternVL2.5-78B。這一成績的背后,離不開英偉達在模型訓練策略上的創新。

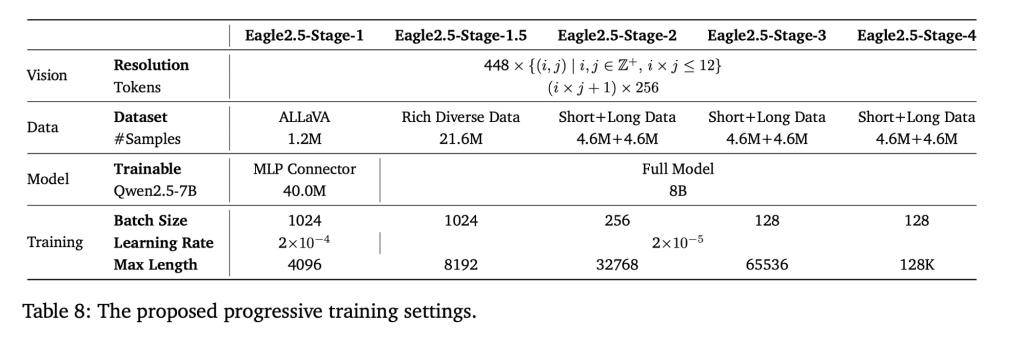

為了提升模型的性能,英偉達采用了兩項關鍵訓練策略:信息優先采樣和漸進式后訓練。信息優先采樣技術通過圖像區域保留和自動降級采樣,確保了原始圖像區域的完整性和視覺細節的優化。同時,漸進式后訓練策略通過逐步擴展模型上下文窗口,讓模型在不同輸入長度下都能保持穩定性能,避免了過擬合單一上下文范圍的問題。

Eagle 2.5的訓練數據管道也經過了精心設計。英偉達整合了開源資源和定制數據集Eagle-Video-110K,該數據集專為理解長視頻設計,采用了雙重標注方式。通過自上而下的故事級分割和自下而上的問答對生成,數據集在強調多樣性的同時,確保了敘事連貫性和細粒度標注,為模型在高幀數任務中的表現提供了有力支持。

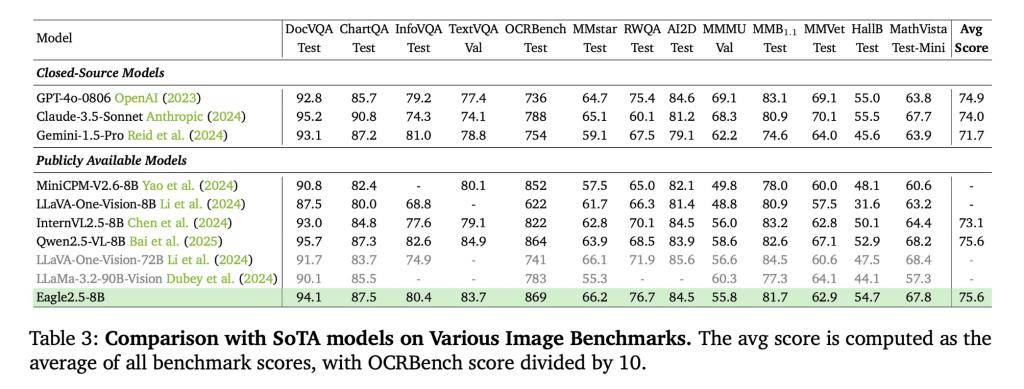

在性能表現方面,Eagle 2.5-8B在多項視頻和圖像理解任務中都展現出了卓越的性能。在視頻基準測試中,它在MVBench、MLVU和LongVideoBench上分別獲得了74.8、77.6和66.4的高分。在圖像基準測試中,它在DocVQA、ChartQA和InfoVQA上也分別取得了94.1、87.5和80.4的優異成績。這些成績充分證明了Eagle 2.5在視覺-語言模型領域的領先地位。

為了進一步驗證模型的有效性,英偉達還進行了消融研究。研究結果表明,移除信息優先采樣和自動降級采樣技術會導致模型性能下降。而加入漸進式訓練和Eagle-Video-110K數據集則能帶來更穩定的性能提升。這一結果進一步證明了英偉達在模型訓練策略和數據集設計上的正確性。