近期,清華大學(xué)沈陽團(tuán)隊的新作《DeepSeek攻略》再度引起廣泛關(guān)注,距離上次分享僅僅三天時間,這一最新成果迅速在網(wǎng)絡(luò)上流傳開來。此次攻略的核心議題,聚焦于AI領(lǐng)域一個頗為引人深思的現(xiàn)象——AI幻覺。

在使用DeepSeek等大語言模型的過程中,不少用戶或許都曾遭遇過這樣一種情況:模型輸出的內(nèi)容看似邏輯通順,實(shí)則與事實(shí)大相徑庭,這便是所謂的“AI幻覺”。這種幻覺不僅令人啼笑皆非,更在某種程度上挑戰(zhàn)了我們對AI準(zhǔn)確性的信任。

在《DeepSeek攻略》的第五部寶典中,AI幻覺被詳細(xì)剖析,其本質(zhì)被揭示為統(tǒng)計概率驅(qū)動下的“合理猜測”。具體而言,AI幻覺主要分為兩類:一是事實(shí)性幻覺,即模型生成的內(nèi)容與可驗(yàn)證的現(xiàn)實(shí)世界事實(shí)不符;二是忠實(shí)性幻覺,即模型生成的內(nèi)容偏離了用戶的指令或上下文。

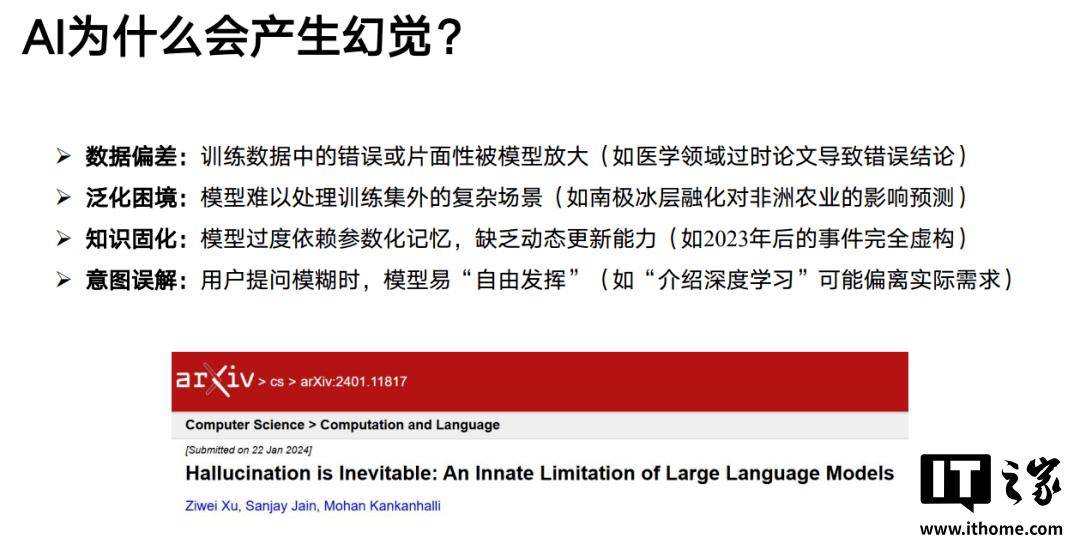

那么,究竟是什么原因?qū)е铝薃I幻覺的產(chǎn)生呢?攻略中給出了幾點(diǎn)解釋:數(shù)據(jù)偏差、泛化困境、知識固化以及意圖誤解。例如,訓(xùn)練數(shù)據(jù)中的錯誤或片面性可能被模型放大,導(dǎo)致模型生成錯誤的內(nèi)容;又如,當(dāng)模型面對訓(xùn)練集外的復(fù)雜場景時,可能難以做出準(zhǔn)確判斷;再比如,模型過度依賴參數(shù)化記憶,缺乏動態(tài)更新能力,導(dǎo)致對新知識一無所知;當(dāng)用戶提問模糊時,模型也可能“自由發(fā)揮”,偏離實(shí)際需求。

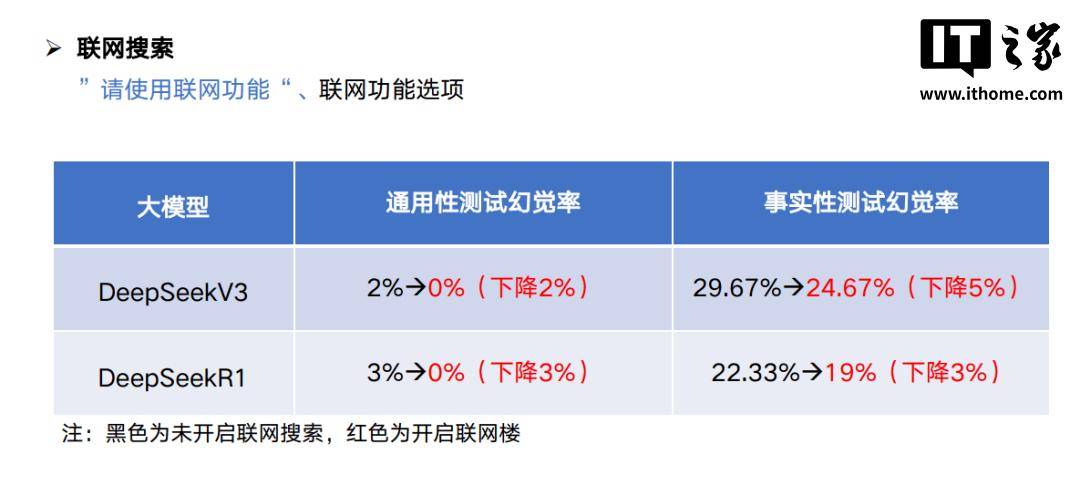

面對AI幻覺這一挑戰(zhàn),我們作為普通用戶又該如何應(yīng)對呢?攻略中提出了幾點(diǎn)實(shí)用建議。首先,可以開啟聯(lián)網(wǎng)搜索功能,讓AI在生成內(nèi)容前對齊信息,從而減少“胡說八道”的幾率。其次,在編寫提示詞時,可以提前做好知識邊界的限定,降低LLM虛構(gòu)的可能性。還可以使用多款A(yù)I模型對生成的結(jié)果進(jìn)行交叉驗(yàn)證,通過對比不同模型的輸出,提高內(nèi)容的準(zhǔn)確性。

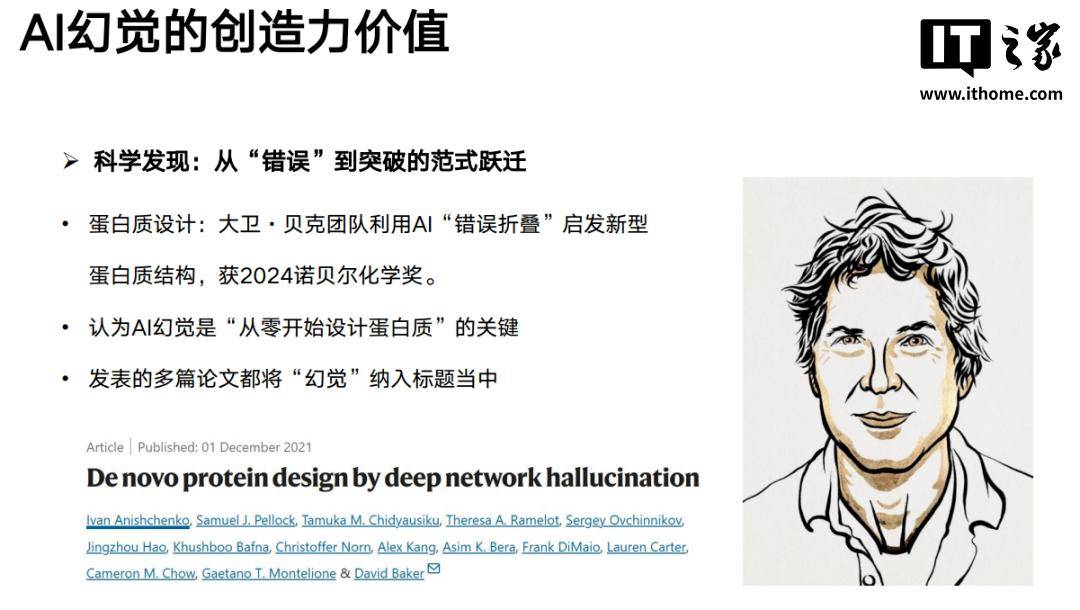

然而,值得注意的是,AI幻覺并非全然無益。在某些需要創(chuàng)造力的領(lǐng)域,幻覺或許正是我們所追求的。當(dāng)然,要讓AI幻覺的“想象力”為我們所用,還需要逐步建立方法論,并經(jīng)過合理的驗(yàn)證過程。

此次《DeepSeek攻略》的分享,不僅讓我們對AI幻覺有了更深入的了解,更為我們提供了應(yīng)對和利用這一現(xiàn)象的有效方法。在未來的日子里,隨著AI技術(shù)的不斷發(fā)展,我們有理由相信,AI幻覺將不再是一個難以克服的難題,而是成為推動創(chuàng)新的重要力量。