摩爾線程今日宣布了一項重大開源舉措,正式推出了MT-MegatronLM與MT-TransformerEngine兩大AI框架。這一舉措標(biāo)志著摩爾線程在國產(chǎn)全功能GPU上實現(xiàn)了混合并行訓(xùn)練和推理的重大突破。

據(jù)摩爾線程官方介紹,MT-MegatronLM是一個專為全功能GPU設(shè)計的開源混合并行訓(xùn)練框架。它不僅能夠支持dense模型和多模態(tài)模型的高效訓(xùn)練,還特別擅長處理MoE(混合專家)模型。而MT-TransformerEngine則專注于Transformer模型的訓(xùn)練與推理優(yōu)化,通過一系列技術(shù)革新,如算子融合和并行加速策略,充分挖掘了摩爾線程全功能GPU的計算潛力。

兩大框架的技術(shù)亮點(diǎn)在于硬件適配與算法創(chuàng)新的深度融合。其中,混合并行訓(xùn)練技術(shù)能夠靈活應(yīng)對不同模型架構(gòu)的復(fù)雜運(yùn)算場景,而FP8混合訓(xùn)練策略則結(jié)合摩爾線程GPU原生支持的FP8混合精度訓(xùn)練,有效提升了訓(xùn)練效率。高性能算子庫muDNN與通信庫MCCL的深度集成,進(jìn)一步優(yōu)化了計算密集型任務(wù)和多卡協(xié)同的通信開銷。

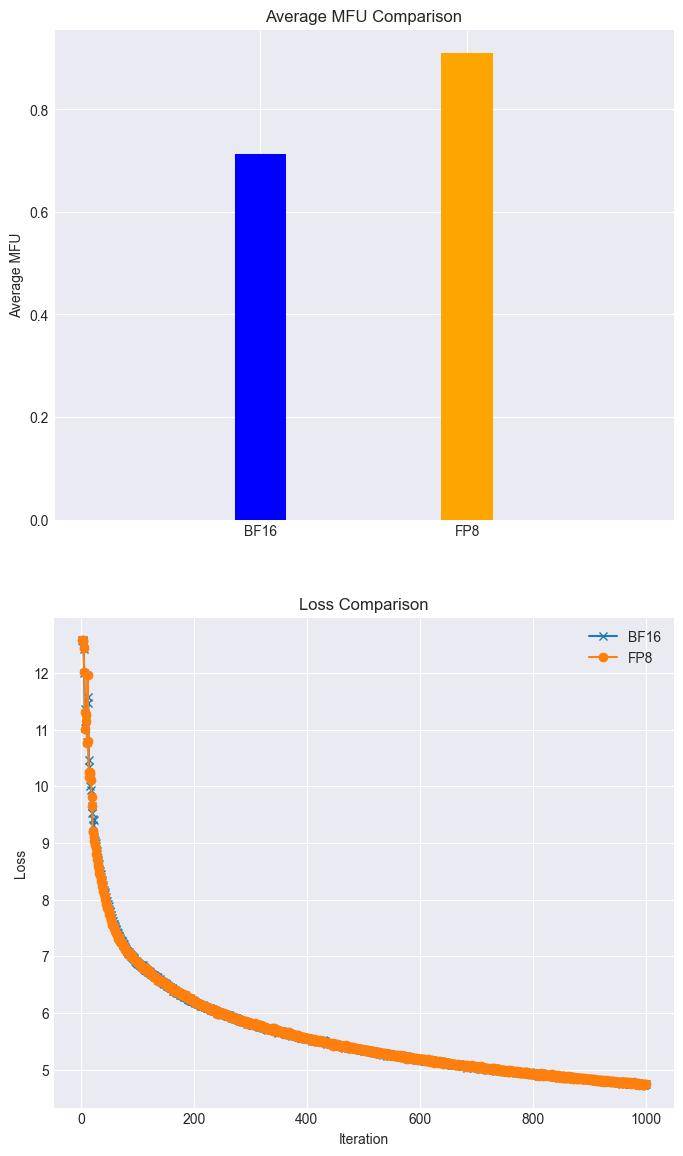

在實際應(yīng)用方面,摩爾線程展示了令人矚目的成果。在全功能GPU集群上,Llama3 8B模型的訓(xùn)練任務(wù)在FP8混合精度加速技術(shù)的加持下,實現(xiàn)了28%的加速,且loss幾乎無損。同時,摩爾線程還成功復(fù)現(xiàn)了DeepSeek滿血版訓(xùn)練流程,展示了其對復(fù)雜AI訓(xùn)練任務(wù)的高效支持。

兩大框架還具備完善的異常處理和兼容性。內(nèi)置的rewind異常恢復(fù)機(jī)制能夠自動回滾至最近穩(wěn)定節(jié)點(diǎn)繼續(xù)訓(xùn)練,確保了大規(guī)模訓(xùn)練的穩(wěn)定性。同時,兩大框架兼容GPU主流生態(tài),為開發(fā)者構(gòu)建自有的AI技術(shù)棧提供了底層支撐。

摩爾線程官方表示,他們將持續(xù)優(yōu)化MT-MegatronLM與MT-TransformerEngine框架,并引入更多先進(jìn)功能。未來,用戶將能夠體驗到Dual Pipe / ZeroBubble并行策略帶來的更高并行訓(xùn)練效率,以及多種FP8優(yōu)化策略帶來的性能和穩(wěn)定性提升。異步checkpoint策略和優(yōu)化后的重計算策略也將進(jìn)一步提高訓(xùn)練過程中的容錯能力和效率。

摩爾線程的這一開源舉措無疑為AI領(lǐng)域注入了新的活力。通過開放兩大核心框架,摩爾線程不僅展示了其在國產(chǎn)GPU技術(shù)上的深厚積累,也為廣大開發(fā)者提供了一個強(qiáng)大的AI開發(fā)平臺。未來,隨著框架的不斷優(yōu)化和功能的持續(xù)引入,我們有理由相信,摩爾線程將在AI領(lǐng)域取得更加輝煌的成就。

對于感興趣的開發(fā)者和研究人員,可以通過以下鏈接獲取兩大框架的開源代碼:

MT-MegatronLM開源地址:https://github.com/MooreThreads/MT-MegatronLM

MT-TransformerEngine開源地址:https://github.com/MooreThreads/MT-TransformerEngine

摩爾線程Simumax開源地址:https://github.com/MooreThreads/SimuMax