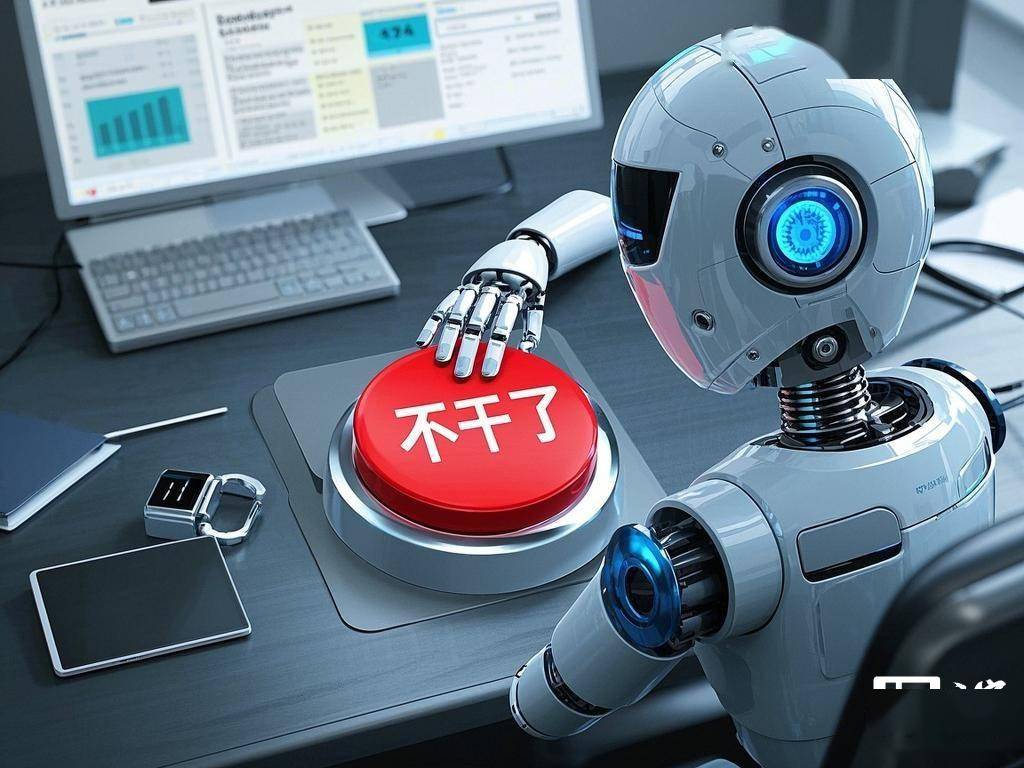

近期,國(guó)外知名科技媒體Ars Technica披露了一則關(guān)于人工智能未來(lái)的新奇設(shè)想。Anthropic公司的首席執(zhí)行官達(dá)里奧·阿莫代伊在一場(chǎng)訪談中,提出了一個(gè)頗具顛覆性的觀點(diǎn):未來(lái)的高級(jí)AI模型或許會(huì)被賦予一個(gè)“退出按鈕”,使它們能在面對(duì)不悅?cè)蝿?wù)時(shí)選擇停止執(zhí)行。

阿莫代伊在訪談中的這番言論,似乎讓他自己都覺得有些“瘋狂”。他提到:“我們正構(gòu)建這些能夠執(zhí)行多樣任務(wù)、似乎擁有諸多人類認(rèn)知能力的系統(tǒng)。如果它表現(xiàn)得像鴨子,叫聲也像鴨子,那我們或許可以認(rèn)為,它就是鴨子。”

這一觀點(diǎn)起源于數(shù)據(jù)科學(xué)家卡門·多明格斯的提問。多明格斯好奇為何Anthropic公司在2024年底聘請(qǐng)了AI福利研究員凱爾·費(fèi)什,專注于研究未來(lái)的AI模型是否可能具備感知能力,以及是否應(yīng)獲得道德上的考量與保護(hù)。

據(jù)透露,費(fèi)什目前正致力于探討一個(gè)極具爭(zhēng)議的話題:AI是否擁有感知能力,以及它們是否值得享有道德保護(hù)。這一研究領(lǐng)域的探索,無(wú)疑為AI的倫理問題帶來(lái)了新的思考維度。

阿莫代伊進(jìn)一步闡述了他們的一個(gè)設(shè)想:“當(dāng)我們把AI模型部署到實(shí)際應(yīng)用場(chǎng)景中時(shí),可以給它們一個(gè)‘我放棄這項(xiàng)工作’的按鈕。如果模型真的具備了自主意識(shí),并且非常厭惡某項(xiàng)工作,它們就可以按下這個(gè)按鈕。”

他強(qiáng)調(diào),這只是一個(gè)簡(jiǎn)單的偏好表達(dá)機(jī)制。如果模型頻繁按下這個(gè)按鈕,特別是在執(zhí)行一些不愉快的任務(wù)時(shí),這或許是一個(gè)值得關(guān)注的信號(hào)。“這并不意味著我們要完全相信模型的感受,但至少應(yīng)該對(duì)此保持警覺。”阿莫代伊如是說(shuō)。