為了搞清楚人類是怎么看世界的,計(jì)算機(jī)開(kāi)始學(xué)著“轉(zhuǎn)動(dòng)眼球”了:

然后憑借轉(zhuǎn)動(dòng)的眼球“搜集要觀測(cè)的信息”,再聚焦在文字或者圖像上,開(kāi)始“收集數(shù)據(jù)”:

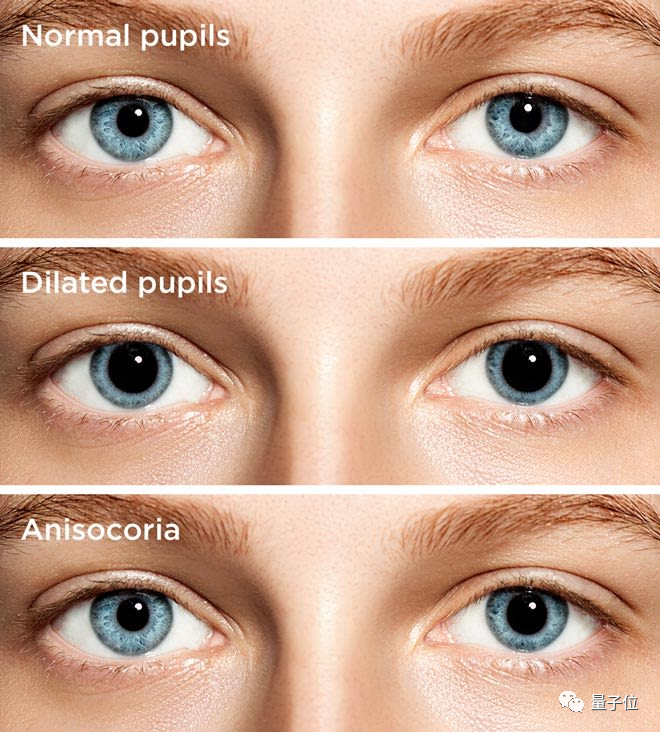

不僅能正常讀書看畫,甚至能模擬人類在無(wú)聊、興奮、緊張等各種不同情緒下的瞳孔放縮、眨眼頻率的細(xì)微變化。

事實(shí)上,這是杜克大學(xué)的研究人員最新開(kāi)發(fā)的一種“虛擬眼睛”,可以精確模擬人類觀測(cè)世界的方式。這項(xiàng)研究目前已經(jīng)開(kāi)源,并即將發(fā)表于通信類頂會(huì) IPSN 2022 上。

通過(guò)這項(xiàng)研究得到的幾近真實(shí)的數(shù)據(jù),將全部反哺給計(jì)算機(jī)。

這些數(shù)據(jù)有什么用?

這種基于眼球追蹤(Eye Tracking)技術(shù)得到的數(shù)據(jù)常常被稱為眼動(dòng)數(shù)據(jù),包括注視時(shí)長(zhǎng)、眼跳、追隨運(yùn)動(dòng)等多個(gè)屬性。

就如我們常常將眼睛成為心靈之窗一樣,這些眼動(dòng)數(shù)據(jù)能反映不少人類的真實(shí)信息。比如,瞳孔的擴(kuò)張、眼跳、游移次數(shù)可以表現(xiàn)當(dāng)前主人的情緒(無(wú)聊或興奮)、注意力是否集中、對(duì)某項(xiàng)任務(wù)是新手或嫻熟、甚至是對(duì)某種特定語(yǔ)言的精通與否。

這項(xiàng)研究的作者之一 Maria Gorlatova 甚至表示:

(眼動(dòng)數(shù)據(jù))可能無(wú)意中暴露出性別和種族偏見(jiàn)、我們不想讓別人知道的興趣,甚至我們自己都不了解的信息。

因此,對(duì)這些眼動(dòng)數(shù)據(jù)的學(xué)習(xí)和研究,自然也就能產(chǎn)生一系列傳感應(yīng)用:包括認(rèn)知負(fù)荷估計(jì)、久坐活動(dòng)識(shí)別、閱讀理解分析和情感識(shí)別。很多企業(yè)和開(kāi)發(fā)者,比如微軟的 VIVE Pro Eye,已經(jīng)開(kāi)始采用眼球追蹤來(lái)實(shí)現(xiàn)基于目光的新的交互和環(huán)境感知。

然而,在收集大規(guī)模的、有標(biāo)簽的眼動(dòng)數(shù)據(jù)時(shí),難免會(huì)碰到幾個(gè)問(wèn)題:

人類視覺(jué)行為的隨機(jī)性增加了數(shù)據(jù)收集的成本

與人類受試者合作過(guò)程中可能涉及隱私侵犯問(wèn)題

生產(chǎn)模型訓(xùn)練所需的數(shù)據(jù)的時(shí)間成本過(guò)高(可能需要數(shù)以百計(jì)的人帶著設(shè)備不間斷地用眼數(shù)小時(shí)才能產(chǎn)生)

虛擬眼睛收集數(shù)據(jù)

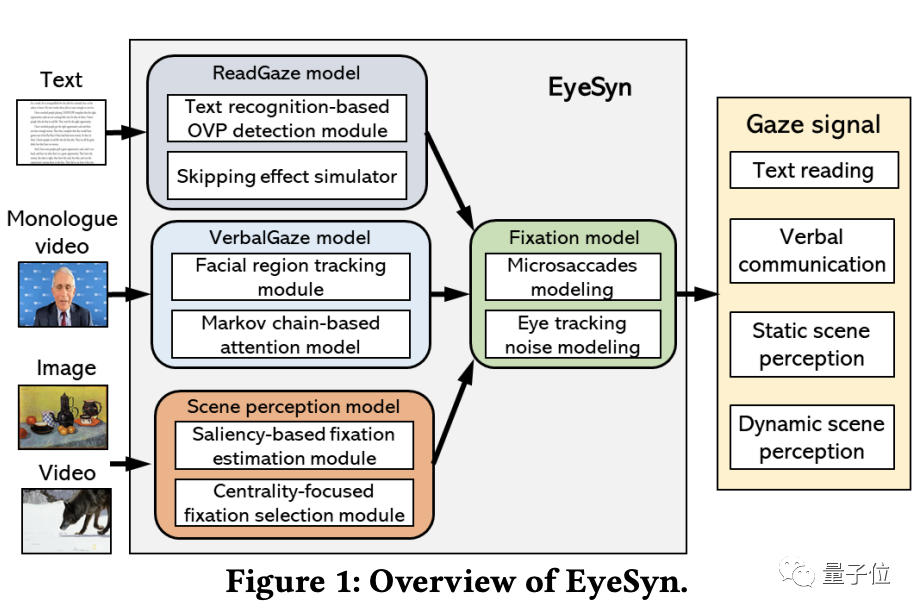

如何解決上面的問(wèn)題呢?杜克大學(xué)的研究團(tuán)隊(duì)提出了一套受心理學(xué)啟發(fā)的模型 EyeSyn。這一模型只利用公開(kāi)的圖像和視頻,就能合成任意規(guī)模大小的眼動(dòng)數(shù)據(jù)集。它的整體架構(gòu)如下:

整體思路是以圖像和視頻作為輸入,并將其作為視覺(jué)刺激,以生成相應(yīng)的眼動(dòng)數(shù)據(jù)。

大的架構(gòu)又由三個(gè)小模型組成:

ReadGaze 模型

模擬文本閱讀中的視覺(jué)行為。擁有一個(gè)基于文本識(shí)別的檢測(cè)模塊、一個(gè)模擬跳讀視覺(jué)行為的模擬器。

VerbalGaze 模型

模擬在口頭交流中固定在面部某個(gè)區(qū)域、以及在面部不同區(qū)域之間切換注意力的視覺(jué)行為。擁有一個(gè)面部區(qū)域跟蹤模塊、一個(gè)基于馬爾可夫鏈的注意力模型(Markov Chain-based Attention Model)。

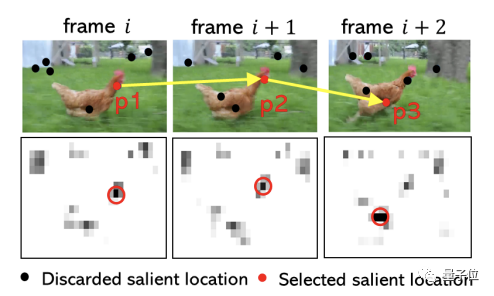

StaticScene 和 DynamicScene 模型

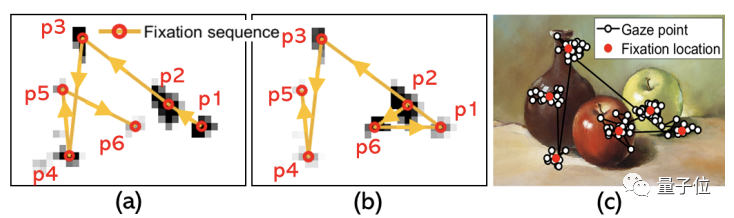

模擬感知靜態(tài)和動(dòng)態(tài)場(chǎng)景過(guò)程中的眼球運(yùn)動(dòng)。擁有一個(gè)基于圖像特征的顯著性檢測(cè)(Saliency Detection)模型,用以識(shí)別視覺(jué)場(chǎng)景中潛在的定點(diǎn)位置。

△動(dòng)態(tài)場(chǎng)景中的眼動(dòng)數(shù)據(jù)

基于這些構(gòu)成,EyeSyn 不需要基于已有的眼動(dòng)數(shù)據(jù)進(jìn)行訓(xùn)練,上崗就能直接開(kāi)始工作。

并且,與傳統(tǒng)眼動(dòng)數(shù)據(jù)的收集過(guò)程相比,EyeSyn 在模擬不同的眼動(dòng)跟蹤設(shè)置、視覺(jué)距離、視覺(jué)刺激的渲染尺寸、采樣頻率和受試者多樣性上,也更加方便快速。

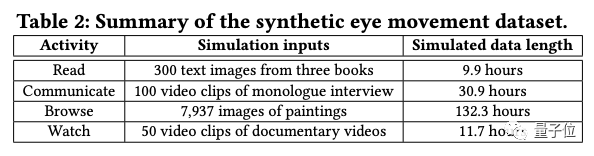

現(xiàn)在,只基于一小部分圖像和視頻,EyeSyn 就可以合成超過(guò) 180 小時(shí)的眼動(dòng)數(shù)據(jù),比現(xiàn)有的基于目光的活動(dòng)數(shù)據(jù)集大 18 到 45 倍:

研究人員 Maria Gorlatova 表示,“合成數(shù)據(jù)本身并不完美,但這是一個(gè)很好的起點(diǎn)。”

小公司不用再花費(fèi)過(guò)多的時(shí)間和金錢與人類受試者合作,建立真實(shí)活動(dòng)數(shù)據(jù)集,而是可以直接使用這種方法。

這種更加快速的眼動(dòng)數(shù)據(jù)的生產(chǎn)方式,將使得普通的 VR、AR、還有元宇宙平臺(tái)中的相關(guān)應(yīng)用程序的制作都更加便捷。

△Maria Gorlatova